Ibercaja Gestión | Este análisis examina el ciclo de inversión sin precedentes impulsado por la inteligencia artificial y su impacto en la expansión en los centros de datos. Evalúa los principales cuellos de botella estructurales, las fuentes de financiación y los sectores beneficiados. Analiza la sostenibilidad económica de la inversión y los riesgos asociados a su monetización.

1. La inversión en IA

El crecimiento de la demanda de computación de alto rendimiento para el procesamiento de datos ha sido exponencial en los últimos dos años. Desde el nacimiento de la inteligencia artificial (IA), la necesidad de procesar datos se ha multiplicado.

Los modelos de IA requieren potencia de computación tanto para ser entrenados, como para ser usados. Esta potencia de computación se proporciona a través de centros de datos, que son instalaciones diseñadas para optimizar las tareas de almacenamiento y proceso de datos en grandes volúmenes. Allí se almacenan y procesan los datos de forma segura, con sistemas especiales de electricidad y refrigeración para que nada se apague ni se estropee, funcionando las 24 horas del día para que todo esté siempre disponible.

En consecuencia, la elevada demanda de procesamiento de datos requiere que la oferta de centros de datos se incremente a un ritmo similar, ya que de lo contrario se crea un cuello de botella que impide procesar toda la demanda.

Esta relación entre crecimiento de la demanda de procesamiento de datos y los centros de datos ha llevado a que la inversión en estos segundos sea un aspecto clave para el desarrollo de la IA, y ha provocado que las grandes empresas tecnológicas, que quieren tener un papel relevante en este nuevo desarrollo, inviertan cantidades extraordinarias de recursos.

1.1. La inversión en números

Las cifras de inversión requeridas son inmensas en todas las estimaciones. Las proyecciones basadas en el análisis de los proyectos ya anunciados y los que se estima que tendrán que llegar para sostener toda la demanda proyectan que la inversión acumulada en centros de datos hasta 2030 puede alcanzar los ~$5,0 trillones.

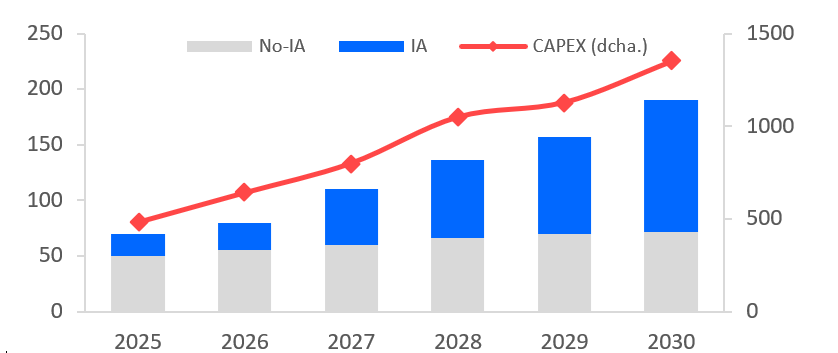

La capacidad de los centros de datos se mide por su consumo de energía -históricamente en MW, pero ahora ya en GW-. Las estimaciones actuales parten de los proyectos ya anunciados. Como los centros de datos tienen un periodo de construcción y puesta en marcha que puede alargarse hasta 5 años, la capacidad instalada para 2030 debería ser fácil de proyectar. Los proyectos actualmente previstos, y que se espera que se terminen produciendo, sitúan la capacidad instalada en 2030 cerca de los 200GW, representando la IA cerca de ~130GW y prácticamente la totalidad de la inversión en centros de datos en los próximos años. En términos de crecimiento, esto supone un incremento de 42% CAGR 25-30. Como es probable que el crecimiento continue más allá de 2030, la inversión estimada para el periodo es superior, ya que cubre parte de los desarrollos que llegaran en forma de capacidad de computación posteriormente a 2030.

Se espera que EE. UU. sea el mayor inversor en centros de datos y que gran parte de la nueva capacidad de procesamiento se instale en tierras estadounidenses. La inversión actual prevista está determinada a producirse cerca de un 60% en EE. UU., mientras que China sería la segunda economía con algo más del 20% y Europa se quedaría atrás con el 10%.

2. ¿Qué puede limitar el crecimiento futuro de los centros de datos?

La disponibilidad energética es quizás el principal factor de riesgo de generación de cuellos de botella operativos. De acuerdo con BofA, los factores relacionados con la energía representan más del 40% de los criterios de decisión a la hora de decidir dónde construir un centro de datos. Teniendo en cuenta que todos los hyperscalers tienen objetivos ESG agresivos (i.e. cero emisiones netas), las energías renovables y el gas natural son, en general, lo que debería alimentar el auge de los centros de datos.

Más allá de la generación, el acceso a la energía es el principal riesgo para el crecimiento de los centros de datos. Según una reciente encuesta de Schneider Electric, el 92% de los encuestados considera que, en EE. UU., las limitaciones de la red eléctrica son un reto. Para cubrir potenciales déficits de energía, se barajan soluciones como 1) convertir las instalaciones de minería de criptomonedas en centros de datos 2) la ubicación de centros de datos en grandes centrales nucleares estadounidenses y 3) construir nuevas centrales eléctricas de gas natural.

Por su parte, las actividades que consumen mucha electricidad son muy intensivas en el uso de cobre, ya que es el mejor elemento para transmitir la electricidad. Actualmente, el precio del cobre se sitúa en niveles de máximos históricos. Sin embargo, este super-ciclo del cobre no se debe exclusivamente al boom de los centros de datos, ya que el consumo de cobre comenzó a incrementarse sustancialmente con la transición hacia la electrificación (renovables, residencial, automóviles, etc.).

En este sentido, la demanda global del cobre ya estaba destinada a superar a la oferta, pero a raíz de la necesidad inminente de construir centros de datos, el efecto se ha intensificado. Por tanto, el potencial desequilibrio entre la oferta y demanda genera incertidumbre acerca del futuro precio y disponibilidad del cobre. De producirse, este factor podría limitar el crecimiento esperado de los centros de datos.

Por otro lado, la alta potencia de cálculo provoca que los chips apilados requieran más energía y generen más calor durante su funcionamiento. Para disipar ese calor, el principal método es mediante el uso de agua, a través de sistemas de refrigeración de aire o líquido. La clave principal es que el agua es significativamente más eficiente transfiriendo el calor que el aire, ya que posee aproximadamente cuatro veces el calor específico del aire y es unas 800 veces más densa, lo que significa que puede absorber alrededor de 3.200 veces más calor que un volumen comparable de aire.

Paradójicamente, los sistemas de refrigeración por aire tienden a usar más agua que los sistemas de refrigeración líquidos. Por ende, los sistemas de refrigeración basados en líquidos terminan consumiendo menos electricidad y, en aplicaciones computacionalmente más demandantes (e.g. entrenamiento de IA), menos agua en total, aunque suelen tener un coste y una complejidad de instalación mayores.

En este contexto, el sector de los centros de datos coincide en general en que la refrigeración de los chips con sistemas de refrigeración líquida es el futuro, al menos para los centros de datos enfocados en IA. Independientemente del método que se utilice para disipar el calor, el agua es necesaria y, en consecuencia, un factor fundamental a la hora de elegir la localización de un centro de datos.

Por último, normativas estrictas en materia de consumo energético, emisiones, uso del agua, soberanía del dato o licencias urbanísticas suelen alargar los plazos de autorización y encarecer la construcción de nuevas instalaciones, reduciendo el atractivo para la inversión. Consecuentemente, la regulación es otro factor que puede limitar el crecimiento de los centros de datos, porque introduce incertidumbre, costes adicionales y restricciones operativas que afectan directamente a su viabilidad económica y velocidad de despliegue.

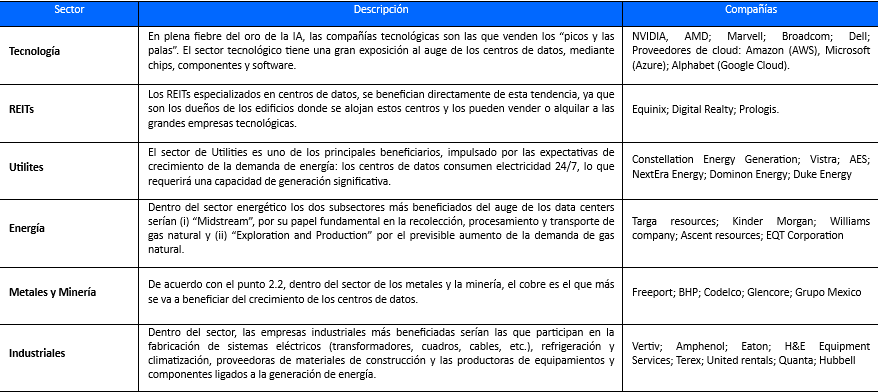

3. ¿Qué sectores se benefician de la inversión en centros de datos?

4. ¿Quién acometerá toda esta inversión?

4.1. Los conocidos como hyperscalers van all-in.

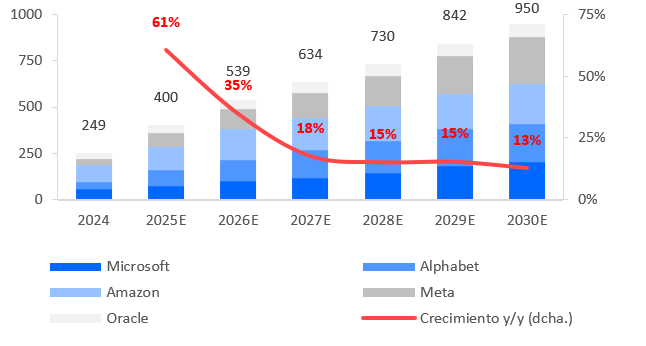

Los hyperscalers lideran la expansión de centros de datos con inversiones masivas. Aunque sus guías de CAPEX son para 2026, los inversores estiman que, para 2030, la inversión actual se duplicará para sostener su infraestructura en la nube.

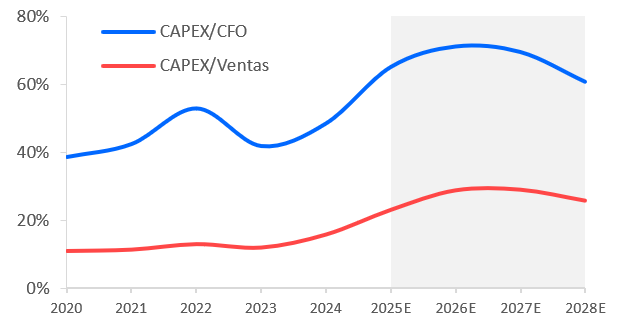

La intensidad con la que los hyperscalers se han lanzado a invertir apenas tiene precedentes. Si nos fijamos en algunas ratios de inversión como CAPEX/Ventas o CAPEX/CFO vemos que los niveles se han disparado y las previsiones para los próximos años siguen siendo muy elevadas.

El incremento de estas ratios se produce además en un conjunto de empresas que año tras año consiguen aumentar sus ventas y flujos de caja operativos a tasas de doble dígito.

Los hyperscalers lideran la inversión en centros de datos para Inteligencia Artificial por cuatro razones estratégicas: (i) su experiencia previa en la nube, (ii) sus masivos canales de distribución para productos como Copilot o Gemini, (iii) su enfoque tecnológico de vanguardia y (iv) su inmensa capacidad financiera, respaldada por flujos de caja robustos y máxima calidad crediticia.

La urgencia de esta carrera inversora responde a tres factores clave:

- Amenaza competitiva: Para gigantes como Google, la IA pone en riesgo su dominio histórico en búsquedas, obligándolos a reaccionar agresivamente.

- Adopción masiva: La demanda de los usuarios crece a un ritmo sin precedentes. Por ejemplo, OpenAI pasó de 100 millones de usuarios semanales en 2023 a más de 800 millones en octubre de 2025.

- Escasez de recursos: Asegurar el suministro de GPUs (dominadas por Nvidia) es vital, ya que los nuevos modelos requieren una potencia de cómputo exponencialmente mayor.

Esta transición está transformando el modelo de negocio de estas empresas. Históricamente centradas en el desarrollo de software (SaaS) y propiedad intelectual —modelos de bajo capital y altos márgenes—, ahora están incrementando drásticamente su CAPEX y activos fijos. Aunque gran parte de estas inversiones aún figura como «obras en curso», su entrada en funcionamiento elevará los costes de amortización.

Existe, por tanto, un riesgo financiero: si la monetización de la IA no avanza al mismo ritmo que la inversión, indicadores como el ROA y el ROIC se verán reducidos. Tradicionalmente, los negocios intensivos en capital no ofrecen los retornos extraordinarios del software puro.

El dominio futuro de la IA dependerá de la capacidad de cómputo. Salvo que veamos una irrupción por parte de China, las empresas que posean los centros de datos serán las que controlen el mercado, aunque esto implique competir ferozmente entre ellas y transformar sus estructuras financieras tradicionales.

4.2. ¿Cómo se va a financiar?

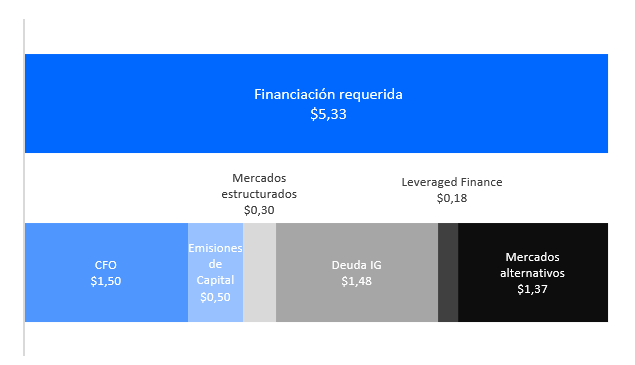

Es fundamental realizar un análisis para ver ya no qué mercado financiará la inversión -por el tamaño deben hacerlo todos-, sino como se estructurará toda la inversión para poder acceder cualquier mercado de capital, ya sea en forma de deuda, emisiones de acciones o crédito ligado al retorno de los activos (ABF). Existen diversas hipótesis sobre en qué medida cada rama podría aportar a la ecuación.

Aunque no existe consenso total sobre las cifras, se estima que las fuentes de financiación para la IA enfrentan techos naturales. Para 2026, el flujo de caja operativo agregado de los hyperscalers rondará los 750.000 millones de dólares. Tras deducir otras inversiones, quedarían unos 300.000 millones anuales para IA, situando el ratio CAPEX/CFO por encima del 50%. No obstante, esto generaría una brecha de financiación de hasta 3,5 billones de dólares.

Para cubrir este déficit, surgirán diversas alternativas:

- Deuda Corporativa Grado de Inversión (IG): Dada su excelente calidad crediticia, empresas como Alphabet, Meta u Oracle ya han emitido bonos significativos, aunque esto ha elevado sus diferenciales de crédito (spreads) entre 20 y 35 puntos básicos. Microsoft y Amazon aún se mantienen al margen, esperando una mayor monetización antes de acudir masivamente a este mercado.

- Financiación Estructurada y Privada: A corto plazo, ganarán peso opciones más sofisticadas como el crédito privado, el leasing y la deuda ligada a activos (ABF). Aunque son más costosas, se adaptan mejor a los ciclos de caja de los centros de datos.

- Inversión estratégica de proveedores: Nvidia está emergiendo como un actor clave, no solo como proveedor, sino como financiador. Un ejemplo es su acuerdo de septiembre de 2025 con OpenAI para invertir hasta 100.000 millones de dólares, destinados en parte a la adquisición de sus propias GPUs.

El capital no parece ser el cuello de botella. El desafío reside en el tiempo: es vital que la monetización masiva de la IA se produzca de forma progresiva para sostener este nivel de inversión sin comprometer la salud financiera de los gigantes tecnológicos.

5. ¿Existe una burbuja? Similitudes con la era de las telecomunicaciones

Creemos que existen diferencias entre este escenario y el de los fiberscalers y, la mayoría van en la línea de desmentir que estemos en una burbuja. A continuación, analizamos las similitudes y diferencias de ambas revoluciones.

i. La adopción de las tecnologías

Un contrapunto que reduce los niveles de alarma y que ya hemos ido comentado es que la adopción de la inteligencia artificial está siendo muy rápida. Gran parte de la inversión de aquella época se canalizó hacia redes de fibra que pretendían revolucionar las telecomunicaciones.

A diferencia de lo que ocurre hoy con los centros de datos, al menos en EE. UU., donde la tasa de ocupación ociosa es minúscula (5%), el uso de las redes de fibra construidas fue mucho más lento.

En 2002, la tasa de ocupación, es decir el contrario de la tasa de ocupación ociosa, no alcanzaba ni el 15%. Cerca del 85% de la capacidad construida tardó años en empezar a usarse.

ii. Diferencias en las compañías que impulsan la revolución

Los actuales hyperscalers presentan una solidez financiera superior. Su capacidad para generar flujo de caja operativo es enorme, lo que les permite autofinanciarse sin recurrir a unos niveles de deuda excesivos.

Mientras las antiguas empresas de fibra operaban con márgenes ajustados, los gigantes tecnológicos actuales disfrutan de un margen neto superior en más de 10 puntos porcentuales. Además, se caracterizan por tener deuda neta nula o incluso excedentes de caja. Esta fortaleza estructural les permite evitar las emisiones de acciones o el apalancamiento que hundieron a los fiberscalers.

iii. Las valoraciones

Las valoraciones actuales sugieren que, a diferencia del sector de telecomunicaciones a principios de siglo, no estamos ante una burbuja. Mientras que en el año 2000 las empresas pasaron de cotizar a un múltiplo PER de 25x a 200x, la revalorización actual de las tecnológicas ha ido acompañada de un crecimiento real en sus beneficios por acción (BPA).

Aunque existe cierta sobrevaloración en activos específicos, la expansión de múltiplos no alcanza niveles irracionales. El contexto macroeconómico exige cautela, ya que el margen para bajar tipos es menor que en décadas pasadas, pero no se percibe una euforia desmedida; los inversores mantienen una vigilancia constante sobre las valoraciones.

En conclusión, los fundamentos actuales distan de crisis pasadas. La clave para la sostenibilidad de esta tendencia será la monetización real de la IA. Habrá que seguir de cerca.

métricas críticas como la tasa de ocupación de los centros de datos, el volumen de tokens procesados y los ingresos de firmas como OpenAI. Aunque eventos de volatilidad son previsibles en el corto plazo, el sentimiento de mercado sigue respaldando esta revolución tecnológica, siempre que la adopción avance según lo previsto.