David Rainville (Sycomore AM/Generali Investments) | La Inteligencia Artificial (IA) lleva más de dos años dando que hablar, pero muchos inversores y observadores siguen preguntándose cuándo esta tecnología alcanzará realmente su punto álgido. Los sucesivos avances que hemos visto en los últimos años -especialmente en grandes modelos lingüísticos (LLM) como el GPT-4- han desatado una notable ola de entusiasmo. Al mismo tiempo, sigue habiendo cierto escepticismo sobre si este impulso puede mantenerse a largo plazo. Mientras tanto, se perfila un importante punto de inflexión: la llegada de los llamados «modelos de razonamiento», o1 y o3 de OpenAI, anunciados para finales de 2024. Se espera que aceleren la adopción de la IA y desencadenen una nueva fase de inversión, haciendo de 2025 un año decisivo para la inteligencia artificial.

En 2023 y 2024, hubo un marcado rumor en torno a la IA, aunque todavía no ha alcanzado la escala de ciclos tecnológicos pasados. Muchos observadores e inversores se han centrado en «modelos fundacionales» como GPT-4. Estos modelos son conocidos por su capacidad para generar rápidamente respuestas sobre una amplia gama de temas o para resumir textos muy extensos y/o complejos, con el consiguiente aumento de la productividad. Sin embargo, hasta ahora estos modelos sólo han resultado útiles para unos pocos casos de uso concretos.

Hasta la fecha, la adopción masiva de las tecnologías Gran modelo lingüístico (LLM por sus siglas en inglés) ha sido relativamente limitada. Los inversores apostaban por el lanzamiento de nuevos modelos básicos, como GPT-5, para aumentar el número de casos de uso y propiciar una rápida adopción. Pero aún se desconoce la fecha de lanzamiento de GPT-5. ¿Por qué? Los avances han sido más lentos de lo esperado, debido a la falta de nuevos datos de alta calidad para entrenar modelos aún más inteligentes.

El revuelo mediático de los dos últimos años ha dado paso a nuevas preguntas: ¿Hemos agotado todos los datos de alta calidad disponibles para entrenar nuevos modelos? ¿Han alcanzado los LLM sus límites técnicos? ¿Se agotará el gasto relacionado con la IA?

Creemos que en 2025 estas incertidumbres deberían remitir, generando más confianza en el tema de la IA. Esto vendrá impulsado por dos factores:

- La llegada de los modelos de razonamiento o1 y o3, anunciados a finales de 2024, que cuentan con capacidades de pensamiento y resolución de problemas mucho más potentes que los actuales modelos fundacionales. Esto debería conducir a una adopción más amplia de las tecnologías de IA generativa por parte de las empresas.

- La demanda de semiconductores y chips de memoria se acelerará como consecuencia de estas nuevas aplicaciones, pero también porque los modelos de razonamiento requieren mucha más potencia de cálculo y memoria que las generaciones anteriores.

Combinados, estos dos factores sugieren un crecimiento sostenido del gasto en IA, que podría superar los 250.000 millones de dólares en 2025 y llegar a los 300.000 millones en 2026, según nuestro análisis.

¿Qué es un «modelo de razonamiento»?

Para entender por qué los modelos de razonamiento son un punto de inflexión, tenemos que distinguir a estos recién llegados de los modelos fundacionales como el GPT-4.

- Modelos de base (LLM): Pueden compararse con vastas bibliotecas de conocimientos. Formule una pregunta a estos modelos y recibirá una respuesta casi instantánea extraída de las masas de información ya introducidas en el modelo durante su proceso de entrenamiento. GPT-4 u otros LLM como PaLM y LLaMA son buenos ejemplos dentro de esta categoría. Estos modelos son muy buenos a la hora de transmitir y resumir todos los datos que se les proporcionan.

- Modelos de razonamiento: Construidos sobre la misma base que los LLM (las tecnologías transformadoras1), los modelos de razonamiento van mucho más allá al introducir una «capa de experiencia» adicional con capacidad para razonar. En la práctica, en lugar de limitarse a bucear en su acervo de conocimientos, los modelos de razonamiento (como o1 y o3) descompondrán la pregunta en varias etapas, desarrollarán una lógica de resolución de problemas y ejecutarán esta estrategia para encontrar una solución, tanto si el problema es complejo como si no tiene precedentes.

Con coeficientes intelectuales estimados de 140 para o1 y casi 160 para o3, estos modelos están cerca de alcanzar el concepto de AGI (Inteligencia General Artificial). De hecho, el modelo o3 se encuentra entre los 200 mejores programadores del mundo, superando a investigadores experimentados (incluido el director de Investigación de OpenAI). Este salto cualitativo supone un cambio de juego para la adopción de la tecnología de IA generativa, ya que abre la puerta a nuevas aplicaciones.

Una nueva perspectiva para la inversión

1. Una nueva fase de formación y creación de datos

Hasta ahora, el entrenamiento de modelos de IA se ha basado en enormes cantidades de texto, imágenes y audio procedentes de Internet y otras fuentes. A varios laboratorios de IA (y a muchos inversores) les preocupaba que estuviéramos a punto de quedarnos sin «datos de alta calidad», lo que amenazaba la mejora continua de los LLM.

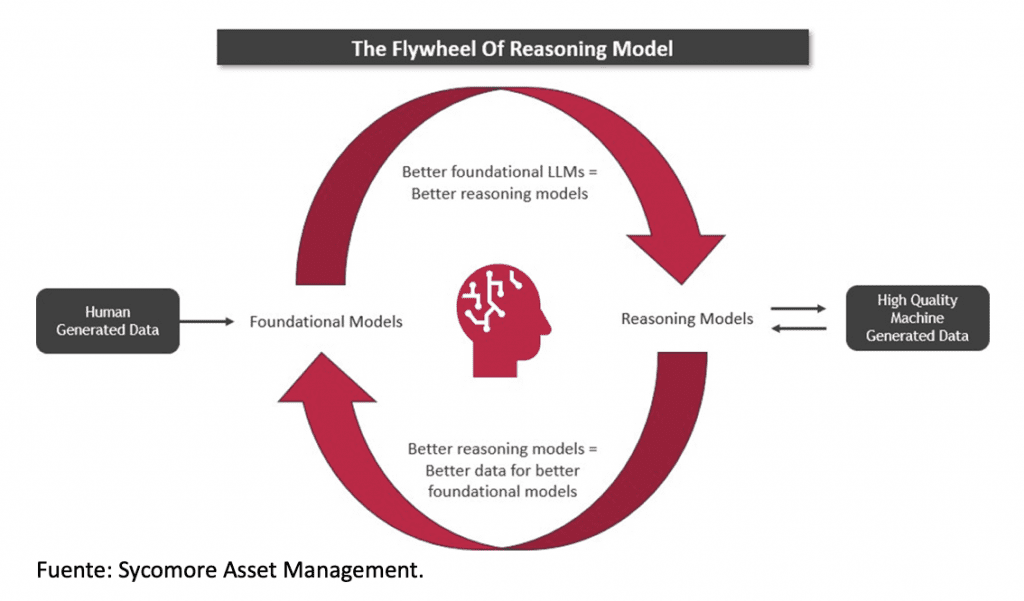

Sin embargo, la llegada de los modelos de razonamiento podría poner patas arriba esa ecuación. Gracias a su capacidad para razonar y generar contenidos más estructurados, o1 y o3 pueden producir por sí mismos «datos sintéticos» que se utilizarán para entrenar futuros modelos de base. En otras palabras, estamos a punto de asistir a un círculo virtuoso en el que la IA contribuye a enriquecer los datos necesarios para su propia evolución.

2. Los costes de inferencia serán mucho más elevados

Los modelos de razonamiento requieren más recursos que los modelos básicos, tanto en potencia de cálculo como en memoria. Algunas estimaciones sugieren que sus costes son entre 10 y 50 veces superiores a los de GPT-4. La razón reside en la fase de «pensamiento» o «inferencia»: en lugar de dar una respuesta instantánea, un modelo como o1 Pro puede «pensar» durante varios minutos para producir una solución detallada y fiable.

Para las empresas, esta inversión extra puede estar justificada si resuelven problemas complejos en los que la precisión tiene más peso que la velocidad. Y para los proveedores de infraestructuras (fabricantes de semiconductores, GPU y memoria de alto ancho de banda [HBM]), este aumento de costes se traduce en una demanda continua -incluso creciente- por parte de los clientes.